Samouczek dotyczący Big Data dla początkujących

big data tutorial beginners what is big data

Ten samouczek wyjaśnia wszystko o podstawach Big Data. Samouczek obejmuje korzyści, wyzwania, technologie i narzędzia wraz z zastosowaniami Big Data:

W tym cyfrowym świecie z postępem technologicznym codziennie wymieniamy duże ilości danych, jak w Terabajty lub Petabajty .

Jeśli codziennie wymieniamy taką ilość danych, musimy ją również utrzymywać i gdzieś przechowywać. Rozwiązaniem do obsługi dużych ilości danych z dużą prędkością i różną różnorodnością jest Big Data.

Może obsługiwać złożone dane pochodzące z wielu źródeł, takich jak różne bazy danych, strony internetowe, widżety itp. Ponadto może łączyć i dopasowywać dane pochodzące z różnych źródeł. Rzeczywiście zapewnia szybszy dostęp do danych ( Na przykład, Media społecznościowe).

Lista samouczków z tej serii Big Data

Samouczek nr 1: Co to jest Big Data? [Ten samouczek]

Samouczek nr 2: Co to jest Hadoop? Samouczek dotyczący Apache Hadoop dla początkujących

Samouczek nr 3: Hadoop HDFS - rozproszony system plików Hadoop

Samouczek nr 4: Architektura Hadoop i przewodnik po poleceniach HDFS

Samouczek nr 5: Samouczek Hadoop MapReduce z przykładami | Co to jest MapReduce?

Samouczek nr 6: Samouczek Apache Hadoop YARN dla początkujących | Co to jest przędza?

Samouczek nr 7: Kompleksowy samouczek dotyczący testowania Hadoop | Przewodnik po testach Big Data

Czego się nauczysz:

Co to jest Big Data?

Samo słowo Ogromne nie wystarczy, aby wyjaśnić BigData, pewne cechy klasyfikują dane w BigData.

Mamy trzy główne cechy BigData i jeśli jakiekolwiek dane spełniają te cechy, będą traktowane jako BigData. ja t jest połączeniem trzech V wymienionych poniżej:

Tom

Prędkość

Różnorodność

Tom : Dane powinny mieć ogromną objętość. Big Data ma rozwiązanie do przechowywania dużej ilości danych, które są w terabajtach lub petabajtach. Możemy łatwo i skutecznie wykonywać operacje CRUD (tworzenie, odczytywanie, aktualizowanie i usuwanie) na BigData.

Prędkość : Odpowiada za szybszy dostęp do danych. Na przykład, w dzisiejszych czasach media społecznościowe potrzebują szybkiej wymiany danych w ułamku czasu, a BigData jest najlepszym rozwiązaniem. Stąd prędkość jest kolejną cechą i jest to szybkość przetwarzania danych.

Różnorodność : W mediach społecznościowych mamy do czynienia z danymi nieustrukturyzowanymi, takimi jak nagrania audio lub wideo, obrazy itp. Ponadto różne sektory, takie jak sektor bankowy, potrzebują ustrukturyzowanych i częściowo ustrukturyzowanych danych. BigData to rozwiązanie pozwalające na przechowywanie obu typów danych w jednym miejscu.

Różnorodność oznacza różne typy danych, takie jak dane strukturalne / nieustrukturyzowane pochodzące z wielu źródeł.

Dane strukturalne : Dane, które mają odpowiednią strukturę lub takie, które można łatwo przechowywać w formie tabelarycznej w dowolnych relacyjnych bazach danych, takich jak Oracle, SQL Server lub MySQL, są znane jako dane strukturalne. Możemy je łatwo i efektywnie przetwarzać lub analizować.

Przykładem danych strukturalnych są dane przechowywane w relacyjnej bazie danych, którą można zarządzać za pomocą SQL (Structured Query Language). Na przykład, Dane pracownika (imię i nazwisko, identyfikator, stanowisko i wynagrodzenie) można przechowywać w formacie tabelarycznym.

W tradycyjnej bazie danych możemy wykonywać operacje lub przetwarzać dane nieustrukturyzowane lub częściowo ustrukturyzowane dopiero po ich sformatowaniu lub dopasowaniu do relacyjnej bazy danych. Przykłady danych strukturalnych to ERP, CRM itp.

Dane częściowo ustrukturyzowane: Dane częściowo ustrukturyzowane to dane, które nie są w pełni sformatowane. Nie jest przechowywany w tabelach danych ani w żadnej bazie danych. Mimo to możemy go łatwo przygotować i przetworzyć, ponieważ te dane zawierają tagi lub wartości oddzielone przecinkami itp. Przykład danych częściowo ustrukturyzowanych to pliki XML, pliki CSV itp.

Dane nieustrukturyzowane: Dane nieustrukturyzowane to dane, które nie mają żadnej struktury. Może mieć dowolną formę, nie ma predefiniowanego modelu danych. Nie możemy go przechowywać w tradycyjnych bazach danych. Wyszukiwanie i przetwarzanie go jest skomplikowane.

Ponadto ilość danych nieustrukturyzowanych jest bardzo duża. Przykład niestrukturalnych danych to treść wiadomości e-mail, dźwięk, wideo, obrazy, uzyskane dokumenty itp.

Wyzwania tradycyjnych baz danych

Tradycyjna baza danych nie obsługuje różnorodnych danych, tj. Nie jest w stanie obsłużyć danych nieustrukturyzowanych i częściowo ustrukturyzowanych.

Tradycyjna baza danych działa wolno, mając do czynienia z dużą ilością danych.

W tradycyjnych bazach danych przetwarzanie lub analiza dużej ilości danych jest bardzo trudna.

Tradycyjna baza danych może przechowywać dane w terabajtach lub petabajtach.

Tradycyjna baza danych nie obsługuje danych historycznych i raportów.

Po pewnym czasie konieczne jest wyczyszczenie bazy danych.

Koszt utrzymania dużej ilości danych jest bardzo wysoki w przypadku tradycyjnej bazy danych.

Dokładność danych jest mniejsza w tradycyjnej bazie danych, ponieważ nie są w niej przechowywane pełne dane historyczne.

Big Data Korzyści w porównaniu z tradycyjną bazą danych

Big Data jest odpowiedzialny za obsługę, zarządzanie i przetwarzanie różnych typów danych, takich jak ustrukturyzowane, częściowo ustrukturyzowane i nieustrukturyzowane.

Jest opłacalny pod względem utrzymywania dużej ilości danych. Działa w systemie rozproszonych baz danych.

Dzięki technikom BigData możemy oszczędzać duże ilości danych przez długi czas. Dzięki temu łatwo jest obsługiwać dane historyczne i generować dokładne raporty.

Szybkość przetwarzania danych jest bardzo duża, dlatego media społecznościowe korzystają z technik Big Data.

Dokładność danych to duża zaleta Big Data.

Pozwala użytkownikom na podejmowanie skutecznych decyzji dla ich biznesu w oparciu o aktualne i historyczne dane.

Obsługa błędów, kontrola wersji i obsługa klienta są bardzo skuteczne w BigData.

Sugerowana lektura => Big Data vs Big Data Analytics vs Data Science

Wyzwania i zagrożenia w BigData

Wyzwania:

Jednym z głównych wyzwań w Big Data jest zarządzanie dużymi ilościami danych. Obecnie dane napływają do systemu z różnych źródeł z różnymi źródłami. Dlatego właściwe zarządzanie tym przedsiębiorstwem stanowi bardzo duże wyzwanie. Na przykład, wygenerowanie raportu zawierającego dane z ostatnich 20 lat wymaga zapisania i utrzymania danych systemu z ostatnich 20 lat. Aby zapewnić dokładny raport, konieczne jest wprowadzenie do systemu tylko odpowiednich danych. Nie powinien zawierać nieistotnych ani zbędnych danych, w przeciwnym razie utrzymanie takiej ilości danych będzie dużym wyzwaniem dla firm. Kolejnym wyzwaniem związanym z tą technologią jest synchronizacja różnych typów danych. Jak wszyscy wiemy, Big Data obsługuje dane strukturalne, nieustrukturyzowane i częściowo ustrukturyzowane pochodzące z różnych źródeł, a ich synchronizacja i uzyskanie spójności danych jest bardzo trudne. Kolejnym wyzwaniem, przed którym stoją firmy, jest brak ekspertów, którzy mogą pomóc i wdrożyć problemy, przed którymi stoją w systemie. W tej dziedzinie istnieje duża luka w talentach. Obsługa aspektu zgodności jest kosztowna. Gromadzenie, agregacja, przechowywanie, analiza i raportowanie danych BigData wiąże się z ogromnymi kosztami. Organizacja powinna być w stanie zarządzać wszystkimi tymi kosztami.

Ryzyka:

Może obsługiwać różnorodne dane, ale jeśli firmy nie mogą właściwie zrozumieć wymagań i kontrolować źródła danych, dostarczy błędne wyniki. W rezultacie zbadanie i skorygowanie wyników zajmie dużo czasu i pieniędzy. Bezpieczeństwo danych to kolejne ryzyko związane z BigData. Przy dużej ilości danych istnieje większe prawdopodobieństwo, że ktoś je ukradnie. Hakerzy danych mogą kraść i sprzedawać ważne informacje (w tym dane historyczne) firmy. Ponadto prywatność danych jest kolejnym zagrożeniem dla BigData. Jeśli chcemy zabezpieczyć dane osobowe i wrażliwe przed hakerami, należy je chronić i przestrzegać wszystkich zasad ochrony prywatności.

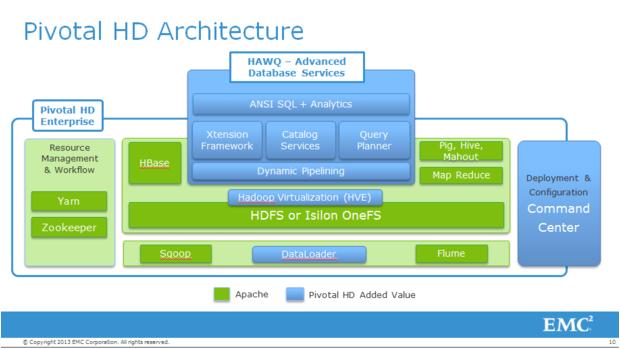

Technologie Big Data

Oto technologie, które można wykorzystać do zarządzania Big Data:

Apache Hadoop Microsoft HDInsight Brak SQL Ul Sqoop BigData w Excelu

Szczegółowy opis tych technologii zostanie omówiony w naszych nadchodzących samouczkach.

Poniżej wymieniono narzędzia typu open source, które mogą pomóc w wykorzystaniu koncepcji Big Data:

1) Apache Hadoop

# 2) Lumify

# 3) Apache Storm

# 4) Apache Samoa

# 5) Elasticsearch

# 6) MongoDB

# 7) BigData systemu HPCC

Zastosowania Big Data

Oto domeny, w których jest używany:

Bankowość Media i rozrywka Służby zdrowia Ubezpieczenie Edukacja Sprzedaż Produkcja Rząd

BigData i hurtownia danych

Hurtownia danych to podstawowa koncepcja, którą musimy zrozumieć przed omówieniem Hadoop lub BigData Testing.

Przyjrzyjmy się hurtowni danych na przykładzie czasu rzeczywistego. Na przykład , jest firma, która otworzyła swoje oddziały w trzech różnych krajach, załóżmy oddział w Indiach, Australii i Japonii.

W każdym oddziale wszystkie dane klientów są przechowywane w Lokalnej Bazie Danych. Te lokalne bazy danych mogą być zwykłymi klasycznymi systemami RDBMS, takimi jak Oracle, MySQL lub SQL Server itp., A wszystkie dane klientów będą w nich przechowywane codziennie.

Teraz co kwartał, co pół roku lub co rok organizacja chce analizować te dane pod kątem rozwoju biznesu. Aby zrobić to samo, organizacja zbierze wszystkie te dane z wielu źródeł, a następnie zgromadzi je w jednym miejscu, a to miejsce zostanie nazwane „Hurtownia danych”.

Hurtownia danych to rodzaj bazy danych, która zawiera wszystkie dane pobrane z wielu źródeł lub wielu typów baz danych za pośrednictwem „ETL” (który jest JEST wyciąg, T ransform i L oad) proces. Gdy dane są już gotowe w Hurtowni Danych, możemy je wykorzystać do celów analitycznych.

Do analizy możemy więc generować raporty z danych dostępnych w Hurtowni Danych. Za pomocą narzędzi Business Intelligence można generować wiele wykresów i raportów.

Potrzebujemy Hurtowni Danych do celów analitycznych, aby rozwijać biznes i podejmować odpowiednie decyzje dla organizacji.

W tym procesie zachodzą trzy rzeczy. Pierwsza polega na tym, że pobraliśmy dane z wielu źródeł i umieściliśmy je w jednej lokalizacji, czyli hurtowni danych.

Tutaj korzystamy z procesu „ETL”, a więc ładując dane z wielu źródeł w jedno miejsce, zastosujemy je w korzeniach transformacji, a następnie będziemy mogli tutaj użyć różnego rodzaju narzędzi ETL.

Gdy dane są gotowe do hurtowni danych, możemy generować różne raporty do analizy danych biznesowych za pomocą narzędzi Business Intelligence (BI) lub nazywamy je również narzędziami raportowania. Narzędzia takie jak Tableau lub Cognos mogą być używane do generowania raportów i tablic DashBoards do analizy danych biznesowych.

OLTP i OLAP

Rozumiemy, czym są OLTP i OLAP?

Nazywane są bazy danych, które są utrzymywane lokalnie i używane do celów transakcyjnych OLTP, czyli przetwarzanie transakcji online. Codzienne transakcje będą tutaj przechowywane i aktualizowane natychmiast, dlatego nazwaliśmy je systemem OLTP.

Tutaj używamy tradycyjnych baz danych, mamy wiele tabel i są relacje, więc wszystko jest systematycznie planowane zgodnie z bazą danych. Nie wykorzystujemy tych danych do celów analitycznych. Tutaj możemy skorzystać z klasycznych baz danych RDMBS, takich jak Oracle, MySQL, SQL Server itp.

Kiedy dochodzimy do części Data Warehouse, korzystamy z Teradata lub Hadoop Systems, które również są rodzajem bazy danych, ale dane w DataWarehouse są zwykle wykorzystywane do celów analitycznych i nazywa się OLAP lub Przetwarzanie analityczne online.

Tutaj dane mogą być aktualizowane co kwartał, co pół roku lub co rok. Czasami dane są również aktualizowane „Offerly”, gdzie Offerly oznacza, że dane są aktualizowane i pobierane do analizy zgodnie z wymaganiami klienta.

Ponadto dane do analizy nie są aktualizowane codziennie, ponieważ będziemy otrzymywać dane z wielu źródeł zgodnie z harmonogramem i możemy wykonać to zadanie ETL. Tak działa system przetwarzania analitycznego online.

Tutaj ponownie narzędzia BI lub narzędzia do raportowania mogą generować raporty, a także pulpity nawigacyjne, na podstawie których ludzie biznesu będą podejmować decyzje dotyczące usprawnienia ich działalności.

Gdzie pojawia się BigData?

BigData to dane, które przekraczają możliwości przechowywania i przetwarzania konwencjonalnych baz danych i są zapisane w formacie strukturalnym i nieustrukturyzowanym, więc nie mogą być obsługiwane przez lokalne systemy RDBMS.

Tego rodzaju dane będą generowane w terabajtach (TB) lub petabajtach (PB) lub poza nimi i obecnie szybko rośnie. Istnieje wiele źródeł pozyskiwania tego rodzaju danych, takich jak Facebook, WhatsApp (które są związane z sieciami społecznościowymi); Amazon, Flipkart związane z e-commerce; Gmail, Yahoo, Rediff związane z e-mailami i Google oraz innymi wyszukiwarkami. Otrzymujemy również duże dane z telefonów komórkowych, takie jak dane SMS, nagrywanie połączeń, dzienniki połączeń itp.

Wniosek

Big data to rozwiązanie umożliwiające wydajną i bezpieczną obsługę dużych ilości danych. Jest również odpowiedzialny za utrzymanie danych historycznych. Jest wiele zalet tej technologii, dlatego każda firma chce przejść na Big Data

Autor: Vaishali Tarey, kierownik techniczny @ Syntel

NEXT Tutorial

metoda analizy danych

Big Data to zbiory danych o dużej objętości, różnorodności, zmienności oraz wartości. Celem pozyskiwania dostępu do tych danych oraz ich przetwarzania jest wspomaganie procesów decyzyjnych, odkrywanie nowych zjawisk oraz optymalizacja procesów.

Big Data to metoda analizy danych, która znajduje zastosowanie w biznesie, samorządach i polityce. Pojęcie to odnosi się do zbiorów danych, których analizowanie, ze względu na ich ogromną skalę, wymaga zastosowania specjalistycznych narzędzi.

Na Big Data składają się 4 wymiary (4V):

volume – ilość danych, liczona w tera- lub petabajtach

variety – różnorodność danych, które pochodzą z różnych, często niespójnych ze sobą źródeł

velocity – szybkość napływania nowych danych i ich analizy, w czasie zbliżonym do rzeczywistego

value – wartość danych; z masy nieistotnych informacji, wyodrębnia te najważniejsze.

Bid Data analizuje różnorodne, zawarte w dużych bazach, informacje. Następnie przetwarza je, nadając im status wiedzy, pomocnej w podjęciu najlepszej, możliwej decyzji.

Jednym Big Data kojarzy się z wielkimi możliwościami, w innych budzi mocne obawy. Stosując Big Data, właściciele banków mogą szacować zdolność kredytową pożyczkobiorców. Firmy finansowe zbierają i analizują informacje o klientach, korzystając m.in. z danych z serwisów społecznościowych, zakupowych, wszelkiego rodzaju systemów informacji marketingowej, baz danych klientów bądź instalując kamery i mikrofony w placówkach. To właśnie wywołuje przerażenie przeciętnych obywateli i sprawia, że Big Data kojarzy się im z inwigilacją i zbieraniem danych, które potem są wykorzystywane przez firmy do realizacji ich celów bez skrupułów.

Specjaliści uspokajają. Tłumaczą, że firmy przetwarzają, analizują i wizualizują dane pobrane legalnie z różnych źródeł. Następnie wyciągane są wnioski i w efekcie końcowym powstaje profil określonej sytuacji, człowieka, który pomaga firmom czy instytucjom w ich działalności.

Zatem Big Data to proces polegający na korzystaniu z danych, a nie sam fakt ich gromadzenia czy pobierania. Wątpliwości wynikają z tego, że ludziom wydaje się, iż dane są pozyskiwane przez firmy w sposób nielegalny, nieetyczny.

Tymczasem dane pochodzą najczęściej z legalnych, wewnętrznych źródeł informacji, czyli własnych zasobów firm. Dla banków na przykład takie źródło stanowią wszelkie działania związane z kontem klienta, czyli jak, kiedy i za co płaci, czy dokonuje pewnych zakupów regularnie, jakie mam wpływy na konto itp. Dane te bank gromadzi w toku bieżącej działalności i udostępnia je klientom po zalogowaniu na konto.

Odpowiednie wykorzystanie danych było w biznesie od zawsze zjawiskiem znanym i bardzo ważnym. Big Data natomiast wnosi znacznie większe możliwości analiz, szybszych, dokładniejszych i wykorzystujących dane z wielu źródeł. W polskich warunkach na Big Data mogą najwięcej zyskać telekomunikacja, banki i firmy ubezpieczeniowe, ale te są mocno ograniczone przepisami prawa.

Dane mogą też wykorzystywać serwisy internetowe, które oferują rozmaite usługi. Istotne znaczenie ma zwrócenie uwagi na zapisy w regulaminie oraz na co użytkownik zezwala, akceptując regulamin. Warto mieć świadomość, że prawo nie pozwala na dowolne szafowanie danymi klientów. W Unii Europejskiej zagadnienie to jest omawiane coraz intensywniej. Toczą się dyskusje, jak chronić użytkowników przed zbieraniem o nich wrażliwych danych, a jednocześnie nie ograniczać samego procesu analizy. Obecne regulacje nie nadążają jednak za firmami i technologią.

Źródło: http://natemat.pl/52911,co-to-jest-big-data-nie-bojcie-sie-na-pewno-nie-inwigilacja; http://www.kredito24.pl/content/tag/big-data

Przełamywanie stereotypów big data

W poprzednim artykule przybliżony został model analityki danych jako usługi, czyli BDaaS (Big Data as-a-Service ). Tym razem z Billem Schmarzo, CTO EMC Corp. (nazywanym też „dziekanem ds. big data”) – podejmujemy próbę obalenia sześciu mitów narosłych wokół analityki dużych zbiorów danych.

CTO EMC demaskuje 6 mitów big data w 5 minut

Zaproszony w czerwcu br. przez Elizabeth Davis, dziekan University of San Francisco School of Management, Bill Schmarzo wziął udział w panelu dyskusyjnym podczas konferencji stowarzyszenia sprzedaży bezpośredniej (Direct Sales Association). W przydzielonym mu 5-minutowym okienku czasowym podjął wyzwanie polegające na zmierzeniu się z sześcioma stereotypami narosłymi wokół big data.

Mit #1: Każda firma potrzebuje strategii big data.

Prawda #1: Niepotrzebna jest strategia big data, lecz strategia biznesowa, która uwzględnia użycie narzędzi big data. Warunkiem osiągnięcia sukcesu przy korzystaniu z big data jest przede wszystkim przyjęcie biznesowej perspektywy. Niezależnie od tego, czy celem jest optymalizacja kluczowych procesów biznesowych czy wynajdywanie nowych możliwości zarabiania pieniędzy lub poprawa satysfakcji klientów – to możliwości wydobywania i czerpania korzyści biznesowych z big data są wszędzie. Niepowodzenia projektów, w których są wykorzystywane big data, nie wynikają z braku możliwości biznesowych, ale z ich nadmiaru. Problem stanowi koncentracja na celu biznesowym i priorytetyzacja.

Mit #2: Inwestowanie w możliwości, jakie dają big data stanowi pierwszy krok w procesie wydobywania cennych informacji z danych.

Prawda #2: Zaczynaj, przede wszystkim mając na uwadze wyznaczony cel biznesowy.

Swoją podróż z big data warto rozpocząć koncentrując się na jednej kluczowej inicjatywie biznesowej. ważnej dla firmy – na wyznaczonym celu do osiągnięcia w ciągu najbliższych 9-12 miesięcy.

Mit #3: Big data są tylko dla dużych firm (big businesses).

Prawda #3: Wszystkie rodzaje przedsiębiorstw mogą i powinny korzystać z ekonomii big data.

Używanie big data (skalowalne architektury sprzętowe zbudowane na ogólnie dostępnych procesorach, narzędziach open source i platformach) – to 20x do 50x tańsze przechowywanie, zarządzanie i analiza danych w porównaniu z tradycyjnymi technologiami danych.

„Ekonomię big data” zapewniają cztery kluczowe funkcjonalności, których zastosowanie pozwala wydobywać z dużych zbiorów danych wartościowe informacje biznesowe:

Dostęp do pełnej historii szczegółowych danych transakcyjnych i operacyjnych organizacji na poziomie jednostki (człowiek, maszyna lub urządzenie). Dostęp do rosnącej ilości danych niestrukturalnych, zarówno ze zbiorów wewnętrznych organizacji (uwagi konsumentów, notatki zespołów sprzedażowych, wymiana e-maili, specyfikacje produktów, zlecenia prac, badania kliniczne), jak i zbiorów zewnętrznych (dotyczących natężenia ruchu miejskiego, pogody, wyceny nieruchomości, zgłoszeń patentowych, badań naukowych, itd.). Analizy „na czas” oparte na danych, pozwalające wyznaczać optymalny czas na podejmowanie określonych działań (na podstawie zaangażowania klienta, korzystania z urządzeń, dzienniku logów). Zastosowanie analityki predykcyjnej (data mining, uczenie maszynowe, cognitive computing) na zbiorach danych wewnętrznych i zewnętrznych, w celu wykrywania problemów lub możliwości na poziomie jednostki.

Mit #4: Koncentracja na danych w celu rozpoznania możliwości przeprowadzenia wartościowych analiz.

Prawda #4: Koncentracja na decyzjach, które zarząd musi podjąć, żeby wspierać realizację wyznaczonych inicjatyw biznesowych. Decyzje są kluczowe, ponieważ stanowią pomost między biznesem a nauką o danych (data science).

Mit #5: Nauka o danych to tajemnicza dyscyplina, pełna złożoności technicznej.

Prawda #5: Nauka o danych polega na identyfikacji tych zmiennych i wskaźników, które pozwalają lepiej przewidywać wydajność.

Mit #6: Data science jest tylko dla badaczy danych (data scientist).

Prawda #6: Użytkownicy biznesowi powinni myśleć jak badacze danych.

Kto jest najlepszym źródłem zmiennych i wskaźników wymienionych w micie #5? Ludzie, którzy na co dzień pracują w swoich branżach – użytkownicy biznesowi (np. kierownicy sklepów, lekarze, pielęgniarki, nauczyciele, technicy, mechanicy, marketingowcy, sprzedawcy, itp.). Żeby zaczęli myśleć „jak badacze danych” (szerzej i bardziej twórczo o potencjalnych zmiennych i wskaźnikach), warto żeby brali pod uwagę następujące kwestie:

zamiast zadawać pytania opisowe o tym, co działo się, formułować predykcyjne pytania dotyczące tego, co może się zdarzyć, oraz opisowe – dotyczące tego, co należy zrobić;

starać się zrozumieć wagę wyników uzyskanych z agregacji wielu różnych zmiennych i danych związanych z określoną kategorią;

rozumieć konsekwencje doświadczeń użytkownika, czyli jak dostarczać wyniki analiz pracownikom, menedżerom i klientom, żeby były dla nich zrozumiałe i wskazywały kierunki działań?

– Pracując z zespołami analityków danych, zdałem sobie sprawę, że powinniśmy zająć się też drugą stroną medalu; musimy nauczyć badaczy danych myśleć jak biznesmeni – podsumowuje Bill Schmarzo CTO i „Dean of Big Data” i dodaje: – Aby efektywniej zaangażować użytkowników biznesowych, zespół naukowy zajmujący się analityką musi m.in. umieć powiązać wyniki analizy z kluczowymi inicjatywami w organizacji, a dokładniej – z kluczowymi decyzjami biznesowymi, które je napędzają.

Na koniec polecam bardzo ciekawy i skłaniający do refleksji film The Human Face of Big Data. Warto poświęcić mu ok. 50 min. Szczególne wrażenie robią wizualizacje dużych zbiorów dynamicznie zmieniających się danych.

Leave a Comment