Statystyka – Porady

Co to jest?

Niezliczone zapytania w wyszukiwarkach, zdjęcia i posty wrzucane codziennie przez ponad miliard użytkowników Facebooka, zapisy obrazów z kamer miejskich, wyniki badań naukowych, informacje z aplikacji mobilnych - nikt nie ma wątpliwości co do tego, że ilość powstających codziennie danych rośnie w zawrotnym tempie. Naukowcy szacują, że obecnie ok. 94% danych jest przechowywanych w formie cyfrowej.1 Dotychczas stosowane metody, takie jak np. relacyjne bazy danych, okazują się niewystarczające. Z pomocą przychodzi tutaj Big Data. Nie wystarczy jednak, że danych jest dużo, aby odwoływać się do tego terminu.

Najpopularniejszą definicją pojęcia Big Data jest tzw. "3 V", sformułowane przez Douga Laneya, analityka META Group, w raporcie z 2001 r. Wg tego podejścia kluczowe są trzy własności:

volume (ang. objętość)

velocity (ang. szybkość)

variety (ang. różnorodność)

Kryterium wielkości zbioru danych jest jednak względne; w zależności od typu danych o dużym zbiorze będziemy mówić w przypadku giga-, tera- lub petabajtów. Jeśli chodzi o szybkość, to w wielu przypadkach wymagana jest obsługa danych w czasie rzeczywistym, co przy dużej ilości danych może być nie lada wyzwaniem. Poza tym dane napływają z dużym natężeniem. Trzecie kryterium natomiast odnosi się do zróżnicowania zarówno typu danych (dane w typowych formatach, dane w formie SMSów, filmów wideo, zdjęć, itd.), jak i ich źródeł (sensory, czujniki, kamery, skanery, portale społecznościowe, itp). Kładzie się jednak nacisk także na znaczenie i możliwości, które daje analiza dużego zbioru danych.

Jak to działa?

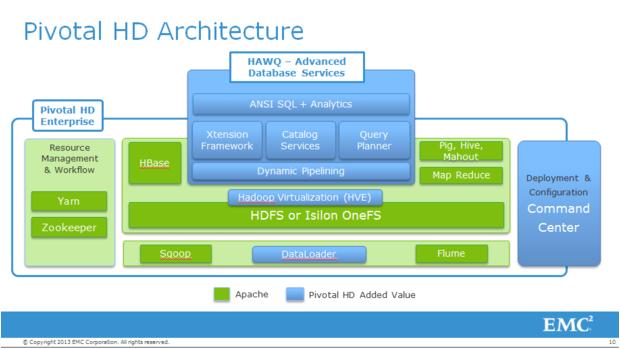

Aby móc skorzystać z dobrodziejstw Big Data, konieczne są trzy elementy. Pierwszym z nich jest źródło danych, co, dzięki współczesnym technologiom dającym sporo narzędzi do zbierania informacji, nie stwarza większych problemów. Kolejny element to odpowiednia platforma do przechowywania i zarządzania danymi. Jednym z najpopularniejszych rozwiązań w tym zakresie jest otwarta platforma programistyczna Apache Hadoop, korzystająca m.in. z rozwiązań zaproponowanych przez Google w zakresie przechowywania rozproszonych plików (Google File System, HDFS) i równoległego przetwarzania ich (MapReduce). Ostatnim, końcowym, elementem jest odpowiednie oprogramowanie, które umożliwia analitykom, menadżerom, itp., dostęp do danych w celu wykonywania odpowiednich analiz. Obecnie większość największych firm (IBM, Microsoft, Google, HP, Oracle) korzysta ze stworzonego przez siebie oprogramowania.2

Nie trzeba jednak być finansowym gigantem, aby móc korzystać z rozwiązań Big Data. Powstało już kilka pakietów w opensource'owym języku R umożliwiających radzenie sobie z obliczeniami na ogromnych zbiorach danych (np. pbdR, bigdata) oraz adaptujących wymienione wyżej technologie w środowisku R (np. RHadoop, SparkR).

Duże zbiory danych stwarzają pole do popisu dla analityków i statystyków. Mogłoby się wydawać, że, korzystając z Big Data, wiemy już wszystko i można porzucić tradycyjne metody statystyczne, w których dużą rolę odgrywa m.in. dbałość o jakość danych, dobór próby czy niepewność. Tymczasem chcąc wnioskować na temat całej populacji np. na podstawie danych pochodzących z Twittera, powinniśmy wziąć pod uwagę, że znacznie częściej korzystają z niego osoby młode. Innym aspektem tego problemu jest fakt, że dużo łatwiej określić korelację pomiędzy zmiennymi niż faktyczny związek przyczynowo-skutkowy między nimi.

A komu to potrzebne?

Wykorzystanie Big Data może przynieść sporo korzyści - od redukcji kosztów czy zwiększenia wpływów w przypadku firm i przedsiębiorstw, aż po zmniejszenie przestępczości czy liczby pożarów w przypadku władz i odpowiednich służb.3

Niejako przełomowym przykładem wykorzystania ogromnej ilości danych było stworzenie przez Google w 2009 roku serwisu Google Flu Trends, który śledził obszar występowania przeziębienia. Nie korzystał on jednak z wyników badań lekarskich, lecz z analizy haseł wpisywanych w wyszukiwarce. Dzięki temu Google przewidywało liczbę zachorowań ze znacznie mniejszym opóźnieniem niż organizacje korzystające z danych z badań lekarskich. W ostatnich latach jednak system ten został mocno skrytykowany, a jego efektywność znacząco spadła.4, 5

Nie mniej jednak ogromny potencjał w wykorzystaniu analizy ogromnych zbiorów danych jest rzeczą niepodważalną, a współpraca w tym zakresie statystyków i informatyków będzie odgrywała coraz bardziej znaczącą rolę – w końcu ilość danych do przeanalizowania wciąż rośnie.

Autor: Barbara Gorzawska

1 [dostęp: 23.06.2016]

2 [dostęp: 23.06.2016]

3 [dostęp: 23.06.2016]

4 [dostęp: 23.06.2016]

5 [dostęp: 23.06.2016]

BIG DATA: rodzaje, funkcje i korzyści

Do 'Big DataAby zrozumieć, musimy najpierw wiedzieć, co 'dane' jest Definiuje słownik Oxford 'dane' jeśli -

„Liczba znaków lub symboli, na których komputer wykonuje operacje, które mogą być przechowywane i przesyłane w postaci sygnałów elektrycznych oraz zapisane na magnetycznych, optycznych lub mechanicznych nośnikach pamięci”.

Tak więc „Big Data” jest podobnie dane ale potem z jednego ogromna objętość. „Big Data” to termin, którego używamy do gromadzenia danych o ogromnych rozmiarach i przechowywania ich w hurtowni danych. W ten sposób objętość może również rosnąć wykładniczo w czasie. Krótko mówiąc, ilość danych jest tak duża i złożona, że nie ma tradycyjnych narzędzi do zarządzania danymi, które mogłyby je efektywnie przechowywać lub przetwarzać. Zarządzanie danymi będzie problem.

Kategorie Big Data

Big Data może mieć trzy formy:

Dane strukturalne. Dane nieustrukturyzowane. Dane częściowo ustrukturyzowane.

Charakterystyczne dla tych formularzy jest przechowywanie w systemie hurtowni danych.

Dane strukturalne

Wszystkie dane, które możemy przechowywać, konsultować i przetwarzać w postaci ustalonego formatu, nazywamy danymi „ustrukturyzowanymi”. Z biegiem czasu inteligentne umysły w informatyce odniosły wiele sukcesów w opracowywaniu technik pracy z takimi danymi (gdzie format jest znany z góry). Udało im się uczynić to opłacalnym dla klienta. Dzisiaj widzi Zarządzanie danymi napotkali problemy wynikające z ilości takich zbiorów danych. Wysokie tempo wzrostu czasami prowadzi do rozmiaru kilku zettabajtów.

Bajt 1 jest równy 10 21 bajtów albo miliard terabajtów

Przy takich danych liczbowych łatwo jest zrozumieć, skąd wzięła się nazwa „Big Data”. Możesz sobie wyobrazić wyzwania związane z przechowywaniem i przetwarzaniem w celu zarządzania danymi. Systemy OLTP są stworzone do pracy z danymi strukturalnymi, w których dane i ich relacje są przechowywane w tabelach.

Dane przechowywane w jednym relacyjna baza danych system zarządzania jest przykładem danych „ustrukturyzowanych”.

Dane nieustrukturyzowane

Zbiory danych o nieznanym kształcie lub strukturze należą do kategorii danych nieustrukturyzowanych. Oprócz tego, że rozmiar jest ogromny, nieustrukturyzowane dane prowadzą do wielu wyzwań w zarządzaniu danymi, jeśli chodzi o uzyskanie wartości dodanej z danych. Typowym przykładem nieustrukturyzowanych danych jest heterogeniczne źródło danych, które zawiera kombinację prostych plików tekstowych, obrazów, filmów itp. Istnieją organizacje, które mają dużą ilość danych, ale niestety nie wiedzą, jak te dane mogą być dla nich przydatne. Te dane mają format nieprzetworzony lub nieustrukturyzowany. Nawiązujemy również do wyszukiwania i ulepszania takich danych data mining.

Przykładem nieustrukturyzowanych danych są wyniki wyszukiwania, które dostarcza nam wyszukiwarka Google.

Dane częściowo ustrukturyzowane

Dane częściowo ustrukturyzowane mogą zawierać obie formy danych. Widzimy dane częściowo ustrukturyzowane jako ustrukturyzowane, ale nie zdefiniowane, jak na przykład definicja tabeli w relacjach DBMS. Przykładem danych częściowo ustrukturyzowanych jest plik XML.

Wzrost danych na przestrzeni lat

Wybuchowy wzrost ilości danych nastąpił po latach 90 po wprowadzeniu Internetu. Ilość danych aplikacji WWW w 2010 była trzy razy większa niż danych OLTP.

Pamiętaj, że dane aplikacji internetowych, które nie są uporządkowane, składają się ze stron internetowych, zdjęć i filmów, ale z plików dziennika, plików historii transakcji itp.

Charakterystyka „Big Data”

(I) Objętość - Sama nazwa „Big Data” odnosi się do rozmiarów, które są ogromne. Rozmiar danych odgrywa kluczową rolę w określaniu wartości, jaką możemy wyprowadzić z danych. Objętość danych decyduje o tym, czy faktycznie możemy uznać dane za duże zbiory danych. Więc 'Tom' jest zawsze cechą, którą musimy wziąć pod uwagę, mając do czynienia z „Big Data”.

(II) Odmiana -Kolejnym aspektem Big Data jest różnorodność.

Różnorodność odnosi się do heterogenicznych źródeł i charakteru danych, które mogą być ustrukturyzowane lub nieustrukturyzowane. Był arkusze kalkulacyjne i bazy danych są jedynymi formami przechowywania rozważanymi dla większości aplikacji. Teraz przechowujemy również dane w postaci e-maili, zdjęć, filmów, urządzeń monitorujących, plików PDF, plików audio i tak dalej. na. Musimy wziąć pod uwagę te formy przechowywania w aplikacjach analitycznych. Różnorodność danych nieustrukturyzowanych stwarza pewne problemy:

Przechowywanie (zarządzanie danymi).

Eksploracja danych.

Analiza danych.

(III) Prędkość -Termin prędkość też 'prędkość' odnosi się do szybkości, z jaką tworzymy dane. Big Data Velocity odnosi się do szybkości, z jaką dane są pobierane ze źródeł, takich jak procesy biznesowe, dzienniki aplikacji, sieci i serwisy społecznościowe, czujniki, urządzenia mobilne i tak dalej. przyjście. Te strumienie danych są ogromne i stałe. Szybkość, z jaką możemy generować i przetwarzać dane, określa rzeczywisty potencjał danych.

(IV) Zmienność -Wskazuje to, jak radzimy sobie z niespójnością, która czasami występuje w danych, dzięki czemu proces jest w stanie skutecznie przetwarzać, kontrolować i filtrować dane.

Korzyści z przetwarzania dużych zbiorów danych

Możliwość przetwarzania „dużych zbiorów danych” ma kilka zalet. To są:

Przy podejmowaniu decyzji organizacje mogą stosować wiedzę z zewnątrz

Organizacje mogą uzyskiwać dostęp do danych społecznościowych z wyszukiwarek i witryn, takich jak Facebook i Twitter strategie biznesowe ulepszyć.

Ulepszona obsługa klienta

Tradycyjne systemy opinii klientów są zastępowane nowymi systemami wykorzystującymi technologie „Big Data”. W tych nowych systemach korzystamy z technologii Big Data i języka naturalnego. W ten sposób możemy czytać i oceniać reakcje konsumentów.

Wczesna identyfikacja ryzyka dla produktu / usług

Lepsza wydajność operacyjna

Dzięki nowym aplikacjom możemy wykorzystać technologie „Big Data” do tymczasowego przechowywania nowych danych, zanim dowiemy się, które dane chcemy umieścić w hurtowni danych. Ponadto integracja aplikacji biznesowych z technologiami „Big Data” i rozwiązaniami hurtowni danych może pomóc w ładowaniu przechowywanych tam „danych czasu rzeczywistego”.

Porozmawiaj z nami LinkedIn.

Ile V jest w Big Data? Jakie są cechy Big Data?

Co to jest Big Data? Nie trudno znaleźć w Internecie jedną z kilku definicji, ale trudniej o faktyczne zrozumienie co kryje się za pojawiającymi się w niej determinantami. Volume, Variety, Velocity. Value – te cechy listowane są w powiazaniu z Big Data najczęściej. Jak można je odszyfrować i co więcej: jakie znaczenia mają dla biznesu? Czy 4V wyczerpują definicję Wielkich Danych? Czy rzeczywiście odróżniają Big Data od tego, co Big Data nie jest?

Volume (Wielkość)

Wielkość jest tym elementem, który przy definiowaniu Big Data pojawia się jako pierwszy. Przyjęło się, że gdy miarą wielkości są gigabajty to prawdopodobnie nie mamy do czynienia z terminem Big Data, a pojawia się ono gdy dotrzemy do poziomu tera – czy petabajtów. Wielkość to również główny katalizator bariery z powodu której tradycyjne systemy zarządzania relacyjnymi bazami danych (RDBMS czyli hurtownie danych, jakie znamy obecnie) nie radzą sobie z Big Data. Podłożem tego problemu jest powikłany związek kosztów, dostępności, czasu trwania zapytania i niezdolności do uporania się z nowymi źródłami nieustrukturyzowanych danych.

Korporacjom duże ilości danych nie są obce. Już w latach 80-tych UPS rozpoczął gromadzenie informacji generowanych podczas procesów logistycznych związanych z obsługą przesyłek. Ich liczba sięgająca ponad 16 mln dziennie generuje ponad 16 PB danych. Amerykański potentat rynku retail Wal-Mart odnotowuje ponad milion transakcji na godzinę, generujących ponad 2,5 PB danych. Podobny poziom wielkości baz danych deklaruje 17% z ankietowanych przez Instytut Gartnera firm, a kolejne 22% określa wielkość swoich zasobów informacyjnych, jako będące na poziomie setek terabajtów.

Co więc jest nowego w zarządzaniu terabajtami danych, skoro prawie 40% firm już to robi? Cóż, innowacyjne w Big Data jest podejście pozwalające na analizę tych wielkich wolumenów danych w połączeniu z nieustrukturyzowanymi źródłami.

Variety (Różnorodność)

Różnorodność jest terminem, którego używamy do określenia wielorakości formatów informacji. To równocześnie cecha, która nie pozwala na przechowywanie ich w strukturalnych bazach danych. Dotyczy to długiej listy obejmującej m.in.: dokumenty tekstowe, maile, wiadomości z kanałów social media, pliki video, audio czy graficzne i wszelkiego rodzaju dane końcowe generowane przez urządzenia IoT (internet of things) czyli sensory, tagi RFID, logi, zapisy sygnałów GPS, etc.

Zaklasyfikowanie ich jako dane nieustrukturyzowane nie oznacza, że nie posiadają żadnej struktury. Niemniej nie pasują do żadnej tradycyjnej bazy danych, nie mogą być także elementem relacyjnego modelu danych. A przyrastają wykładniczo i wg niektórych źródeł stanowią obecnie ponad 90% wszystkich danych zgromadzonych przez biznes.

Różnorodność to również termin, jakim określamy źródła danych, zarówno wewnątrz jak i poza organizacją. Co zmieniło się dzięki Big Data to świadomość, iż ich analiza może naświetlić nowe pola i perspektywy uprzednio przez biznes nie zauważone.

Różnorodność rodzi dwa wyzwania. Pierwsze to efektywne i wydajne przechowanie i przetwarzania tych danych. Drugim jest skojarzenie i zestawienie informacji z różnorodnych źródeł tak by wszelkie posiadane dane dotyczące jednego zdarzenia mógł być spójnie wyciągnięte i przeanalizowane

W końcu należy wspomnieć o powiązaniu pomiędzy wielkością a różnorodnością. Dane niestrukturalne – jak można się domyślić patrząc na ich źródła – przyrastają znaczenie szybciej niż dane strukturalne. Wg Instytutu Gertnera ich ilość podwaja się co 3 miesiące. Szanse biznesowe więc jakie niesie za sobą wykorzystanie różnorodności danych jest języczkiem u wagi inicjatyw związanych z Big Data. Jak wspomniano wyżej, firmy od dawna gromadzą wielkie ilości danych w celach analiz, jednak to możliwość zestawienia ich z insightami i wiedzą ukrytą w nieustrukturyzowanych danych otwiera nowy rozdział analityki biznesowej.

Velocity (Szybkość)

Analitycy, by określić status danych stosują m.in. terminy „data-at-rest” (dane nieaktywne) oraz „data-at-motion” (dane aktywne). Szybkość to cecha, którą przypisujemy tym drugim. Przykładem takich danych jest strumień odczytów z senosora umieszczonego w instalacji inteligentnego domu czy historia logów strony internetowej wraz z listą klików konkretnego jej usera. Nieprzerwane strumienie takich informacji należy przechwycić, zgromadzić i podać obróbce. Zachowanie ich spójności i kompletność to jedno z wyzwań. Zmatchowanie tych danych z odpowiednimi wydarzeniami w świetle ich różnorodności – to kolejne.

Szybkość pozwala też określić prędkość reakcji czyli czy informacja przechwycona została w czasie pozwalającym na jej wykorzystanie czy też opóźnienie czyni ją bezużyteczną.

Ten element ma charakter indywidualny w wymiarze danych. Czy zachowują swoją istotność analityczną permanentnie czy też „starzeją” się z perspektywy analityki i tracą swą wartość? Zrozumienie tego wymiary danych i Velocity w odniesieniu do zbiorów danych które firm przechowuje jest istotne dla ich analizy i pozwala uniknąć wielu błędów.

Trzecim wymiarem szybkości w odniesieniu do danych jest prędkość z jaką musza być przechowywane i pobierane. To jeden z głównych determinantów magazynów NoSQL, zapytań doń i procesów analitycznych, z którymi firma musi się uporać.

Coraz większa jest wśród odbiorców świadomość, iż każdorazowe odwiedziny na portalach o rozbudowanym contencie, jak strony www popularnych dzienników gospodarczych czy portale lifestylowe reklamy, związane są z obcowanie z zestawem reklam przygotowanych specjalnie dla unikalnego użytkownika. U jego podstaw leży dogłębna analiza aktualnie przeglądanych stron, historia poprzednich odwiedzin na danym portalu czy wybranych wizyt w innych adresach. Ta wydawałoby się bezużyteczna pulpa obserwacji przechowywana jest w NoSQL bazach danych i poddawana analizie by optymalnie dobrać zestaw komunikatów. Podobny mechanizm kryje się za rekomendacjami w portalach aukcyjnych czy rozbudowanych e-sklepach.

Architektura przechwytywania, analiz i wdrażania efektów musi wspierać proces zachodzący w czasie rzeczywistym (w tym wypadku ułamki sekund) i wobec tysięcy nowych użytkowników na minutę. Real Time Big Data Analytics (RTBDA) – to obecnie największe wyzwania z jakim Big Data musi się uporać.

Co jednak w tym wymiarze zmieniło się dzięki Big Data ? Strumień informacji zawsze płyną wartko, jednak zdolność do jego uchwycenia (choćby w częściowym wymiarze) i wykorzystania w czasie (prawie)rzeczywistym to narzędzie, które biznes może zastosować i stosuje.

Wartość (Value)

Choć wartość wymienia się jednym ciągiem obok powyższych trzech V, wpływ tej cechy na faktyczne odróżnienie Big Data od „prawie Big Data” jest najbardziej dyskusyjny. W przypadku obu bowiem wysiłek związany z przechowywaniem i przetwarzaniem danych jest celowo powiązany z ich wartością biznesową.

Big Data jednak jest postrzegane jako ten zakres informacji który ma kluczowe znaczenie dla organizacji i tym samym wyróżniający się w relacji kosztów do zysków. Prawdą jest, że o ile uprzednio firmy posiadały i przetwarzały informacji dotyczące segmentów i grup klientów, obecnie ten sam a nawet większy zakres wiedzy w wymiarze pojedynczego klienta pozwala im na personalizowanie oferty skracającej i przyspieszającej proces dostarczenia wartości końcowemu odbiorcy.

Innym wyróżnikiem w zakresie wartości Big Data może być fakt, iż ten typ informacji rzeczywisty potencjał ekonomiczny posiada tylko w powiazaniu ze swoim wolumenem. W świetle wiec relacji do kosztów utrzymania takich danych dopiero zmiany technologiczne i spadek cen storage’u umożliwia wyzwolenie potencjału Big Data.

Plus kolejne V

Do powyższej listy determinantów Big Data często dodaje się kolejne. Większość z nich związanych jest z najbardziej problematycznym elementem wartości. I podobnie jak on, mogą być użyte jako cecha zakresu informacji, ale nie jako unikalna cech wyróżniająca Big Data

Veracity (Wiarygodność): Jakie jest pochodzenia naszych informacji? Czy ich źródło jest autentyczne i miarodajne? W świetle wartości danych i kosztów procesów z nimi związanych odpowiedź na te pytania jest fundamentalna.

Variability (Zmienność): Zmienność w odniesieniu do Big Data określamy jako nieregularność w czasie, co w odniesiniu do wartości danych implikuje pytania o ich zgodność i dostępność czy jednolitość z wydarzeniem do którego się odnoszą. Gdzie leży granica faktycznej przekładalności wnioskowania a „szumu” generowanego przez wielkość analizowanych informacji?

Viscosity (Lepkość): Termin ten jest często używany do określenia przesunięć w czasie danych w stosunku do zdarzeń do których się odnoszą i zestawiany jest z charakterystyką szybkości danych.

Virality (Rozprzestrzenianie): Definiowana przez niektórych, jako właściwość z jaką dane się rozpowszechniają i zostają przypisane do innych zdarzeń czy użytkowników.

Jak każda nowość i Big Data przechodzi okres kształtowania i definiowania, a z czasem uwspólni swoje postrzegania i wejdzie do nomenklatury biznesowej i technologicznej. Czy w jego definiowaniu zachowana zostanie powyższa lista cech czy też ulegnie ona zmianie – nie jest to istotne. Ważny jest biznesowy aspekt i korzyści jakie firmy mogą osiągnąć dzięki wykorzystaniu Big Data. Jest ono bowiem zawsze interesujące, ale bez biznesowych implikacji jest tylko interesujące.

Leave a Comment